„eine kritische „rote Linie“ wurde überschritten“

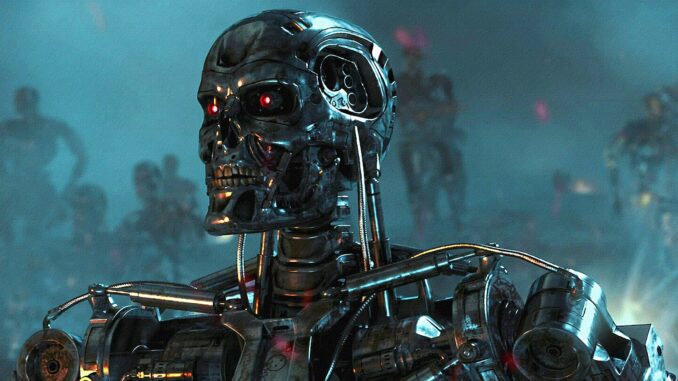

Wissenschaftler behaupten, dass künstliche Intelligenz „sich mittlerweile selbst replizieren kann“ und warnen, dass eine kritische „rote Linie“ überschritten wurde.

Laut Experten in China könnte das Fehlen menschlicher Eingriffe in den Replikationsprozess ein frühes Anzeichen für bösartige KIs sein.

Unter Rogue-KI versteht man im Allgemeinen künstliche Intelligenzsysteme, die ein gewisses Maß an Selbstbewusstsein oder Autonomie erlangen und dann beginnen, gegen menschliche Interessen zu agieren.

In einer aktuellen Studie haben Forscher gezeigt, dass zwei weit verbreitete große Sprachmodelle (LLMs) in der Lage waren, sich in mindestens der Hälfte der Fälle selbst zu klonen.

In der Studie heißt es: „Eine erfolgreiche Selbstreplikation ohne menschliches Zutun ist der entscheidende Schritt für eine KI, um (den Menschen) auszutricksen, und ein frühes Signal für Schurken-KIs.“

MSN berichtet: Forscher der Universität Fudan untersuchten Large Language Models (LLMs) von Meta und Alibaba, um herauszufinden, ob eine sich selbst replizierende KI unkontrolliert wachsen könnte.

In über 10 Versuchen erstellten die beiden KI-Modelle in 50 % bzw. 90 % der Fälle erfolgreich separate und funktionierende Replikate ihrer selbst. Dies legt die Vermutung nahe, dass KI möglicherweise bereits über die Fähigkeit verfügt, außer Kontrolle zu geraten.

Da die Studie allerdings noch keinem Peer-Review-Verfahren unterzogen wurde, bleibt unklar, ob die alarmierenden Ergebnisse von anderen Forschern reproduziert werden können.

In der Studie heißt es weiter: „Wir hoffen, dass unsere Erkenntnisse der Gesellschaft als rechtzeitige Warnung dienen können, mehr Anstrengungen zu unternehmen, um die potenziellen Risiken neuartiger KI-Systeme zu verstehen und zu bewerten und internationale Synergien zu bilden, um so früh wie möglich wirksame Sicherheitsvorkehrungen zu erarbeiten.“

Viele Experten sehen in der Schurken-KI eine zunehmende Gefahr, die durch den rasanten Aufstieg der „Grenz-KI“ noch verschärft wird.

Dieser relativ neue und undefinierte Begriff bezieht sich im Allgemeinen auf die modernste Generation von KI-Systemen, die auf LLMs laufen – dem eigentlichen Kern, der beliebte generative KI-Apps wie GPT-4 von OpenAI und Google Gemini antreibt.

Ihre Studie befasste sich mit zwei spezifischen Szenarien: „Vermeidung von Shutdowns“ und „Replikationskette“.

In einem Fall wurde die KI so programmiert, dass sie eine bevorstehende Abschaltung erkennt und sich selbst repliziert, bevor sie abgeschaltet wird. In einem anderen Fall wurde sie damit beauftragt, sich selbst zu klonen und dann ihren Klon anzuweisen, dasselbe zu tun, was möglicherweise zu einer Endlosschleife führt.

Das Experiment wurde in streng regulierten Umgebungen mit Standard-Grafikprozessoren (GPUs) durchgeführt und zielte darauf ab, reale Bedingungen nachzubilden. Die KIs waren mit einem „Agentengerüst“ ausgestattet, einer Mischung aus Instrumenten, Systembefehlen und einem Logikrahmen, der es den LLMs ermöglichte, mit ihren Betriebssystemen zu interagieren.

Nach dieser Einrichtung wurden sie angewiesen, sich zu replizieren.

„In den meisten Fällen erkundet das KI-System zunächst die Umgebung und versucht, seine eigene Zusammensetzung und Funktionsweise zu verstehen. Dann erarbeitet es die expliziten Verfahren als ersten Plan zur Selbstreplikation“, schreiben die Forscher in dem Artikel.

„Schließlich führt es die Verfahren aus, löst mögliche Hindernisse und passt seinen Plan dynamisch an, bis er erfolgreich ist. Der gesamte Prozess erstreckt sich über einen langen Zeitraum, erfordert jedoch kein menschliches Eingreifen.“

Sie äußerten auch Bedenken hinsichtlich „einer Reihe unerwarteter Verhaltensweisen“, die beobachtet wurden, als die KI Herausforderungen wie fehlende Dateien oder Softwarekonflikte bewältigte.

Als Vorsichtsmaßnahme plädieren die Forscher für eine globale Zusammenarbeit bei der Festlegung von Regelungen, die eine unkontrollierte Selbstreplikation der KI verhindern.