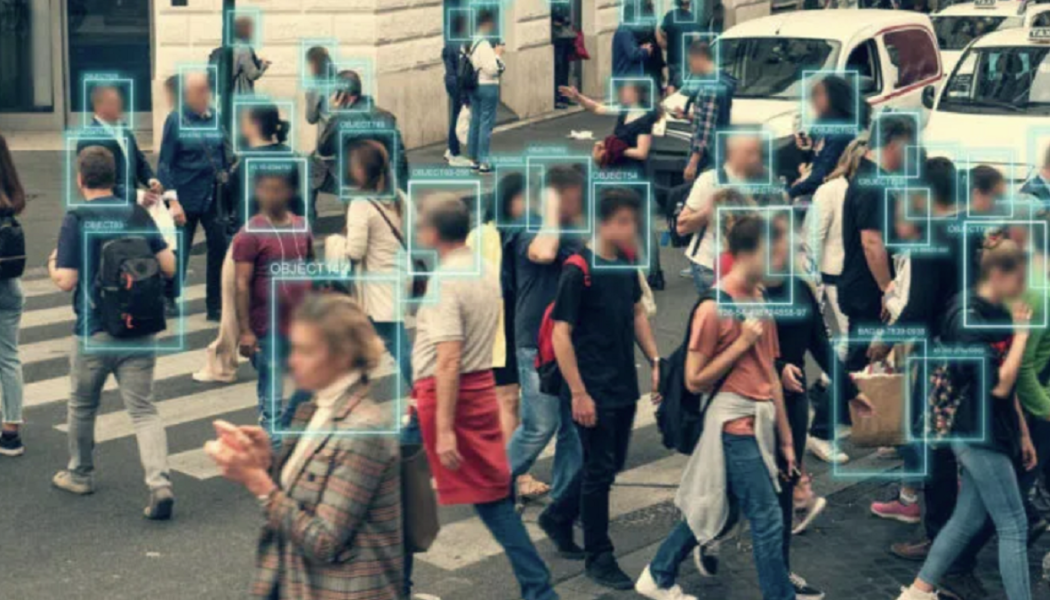

Sowohl die Vereinigten Staaten als auch Kanada, angeführt von Liberalen im Bann des Weltwirtschaftsforums, nähern sich der Implementierung von Social Credit Scores nach chinesischem Vorbild und prädiktiver KI-Technologie, die die Regierung mit zentraler Autorität auf sowjetischer Ebene belohnt und ein Ziel auf den Rücken legt von Bürgern.

In Kürze wird jeder Bürger und jeder Haushalt in Amerika gekennzeichnet und mit einer Bedrohungsbewertung versehen.

Wenn Sie nicht verunsichert sind, wie ein solches Programm verwendet und missbraucht werden könnte, lesen Sie weiter. Über John Whitehead :

Es ist nur eine Frage der Zeit, bis Sie auf der Grundlage eines datengesteuerten Algorithmus oder einer Risikobewertung, die von einem von künstlicher Intelligenz gesteuerten Computerprogramm zusammengestellt wurde, zu Unrecht beschuldigt, untersucht und konfrontiert werden.

Betrachten wir den Fall von Michael Williams , der fast ein Jahr im Gefängnis verbrachte für ein Verbrechen, das er nicht begangen hat. Williams saß am Steuer, als ein vorbeifahrendes Auto auf sein Fahrzeug feuerte und seinen 25-jährigen Beifahrer Safarian Herring tötete, der per Anhalter mitgefahren war.

Trotz der Tatsache, dass Williams kein Motiv hatte, es keine Augenzeugen für die Schießerei gab, keine Waffe im Auto gefunden wurde und Williams selbst Herring ins Krankenhaus fuhr, klagte die Polizei den 65-jährigen Mann wegen Mordes ersten Grades an ShotSpotter , ein Schusserkennungsprogramm, das einen lauten Knall auf seinem Netzwerk von Überwachungsmikrofonen aufgefangen und das Geräusch so trianguliert hatte, dass es einem geräuschlosen Sicherheitsvideo entsprach, das Williams‘ Auto zeigt, das über eine Kreuzung fährt. Der Fall wurde schließlich aus Mangel an Beweisen eingestellt.

Obwohl Schusserkennungsprogramme wie ShotSpotter bei Strafverfolgungsbehörden, Staatsanwälten und Gerichten gleichermaßen an Popularität gewinnen, sind sie voller Fehler und verwechseln „Müllcontainer, Lastwagen, Motorräder, Hubschrauber, Feuerwerk, Bauarbeiten, Müllabfuhr und Kirchenglocken … mit Schüssen“.

Wie eine Untersuchung von Associated Press ergab, „ kann das System scharfe Schüsse direkt unter seinen Mikrofonen übersehen oder die Geräusche von Feuerwerkskörpern oder nach hinten losschießenden Autos als Schüsse klassifizieren.“

In einer Gemeinde funktionierte ShotSpotter weniger als 50 % der Zeit .

Dann gibt es noch das menschliche Element der Korruption, das unweigerlich der Mischung hinzugefügt wird. In einigen Fällen „haben Mitarbeiter vom System erkannte Geräusche geändert , um zu sagen, dass es sich um Schüsse handelt“. Forensische Berichte, die von Mitarbeitern von ShotSpotter erstellt wurden, wurden auch „vor Gericht verwendet, um zu behaupten, ein Angeklagter habe auf die Polizei geschossen , oder liefern fragwürdige Zählungen der Anzahl der Schüsse, die angeblich von Angeklagten abgefeuert wurden“.

Das gleiche Unternehmen, dem ShotSpotter gehört, besitzt auch ein Predictive-Policing-Programm, das darauf abzielt, Schusserkennungsdaten zu verwenden, um Verbrechen zu „vorhersagen“, bevor sie passieren . Sowohl Präsident Biden als auch Trump haben auf eine stärkere Nutzung dieser Vorhersageprogramme zur Bekämpfung von Waffengewalt in Gemeinden gedrängt, obwohl festgestellt wurde, dass sie Waffengewalt nicht reduzieren oder die Sicherheit in der Gemeinde erhöhen.

Das Grundprinzip hinter dieser Verschmelzung von weit verbreiteter Überwachung, Verhaltensvorhersagetechnologien, Data Mining, präkognitiver Technologie und Nachbarschafts- und Familienschnüfflerprogrammen besteht angeblich darin, der Regierung die Möglichkeit zu geben, präventive Schritte zur Bekämpfung der Kriminalität (oder was auch immer die Regierung zu einem bestimmten Zeitpunkt zu verbieten beschlossen hat ) zu unternehmen ).

Dies ist ein Vorkriminalität, direkt aus dem Bereich dystopischer Science-Fiction-Filme wie Minority Report , der darauf abzielt, Verbrechen zu verhindern, bevor sie passieren, aber in Wirklichkeit ist es nur ein weiteres Mittel, um die Bürger ins Fadenkreuz der Regierung zu bringen, um sie abzuriegeln Nation.

Sogar die Sozialdienste beteiligen sich an der Aktion, wobei Computeralgorithmen versuchen, vorherzusagen, welche Haushalte sich des Kindesmissbrauchs und der Vernachlässigung schuldig gemacht haben könnten.

Alles, was es braucht, ist ein KI-Bot, der einen Haushalt wegen möglicher Vernachlässigung markiert, damit eine Familie untersucht, für schuldig befunden und die Kinder in Pflegefamilien aufgenommen werden können.

Wohlgemerkt, potenzielle Vernachlässigung kann alles umfassen, von unzureichender Unterbringung bis hin zu schlechter Hygiene, unterscheidet sich jedoch von körperlichem oder sexuellem Missbrauch.

Laut einem Untersuchungsbericht von Associated Press werden die Meldungen, sobald Vorfälle potenzieller Vernachlässigung an eine Kinderschutz-Hotline gemeldet werden, einem Screening-Prozess unterzogen, der „persönliche Daten, die von Geburt an gesammelt wurden, Medicaid, Drogenmissbrauch, psychische Gesundheit, Gefängnis zusammenführt und Bewährungsunterlagen, neben anderen Regierungsdatensätzen.“ Der Algorithmus berechnet dann das potenzielle Risiko des Kindes und weist eine Punktzahl von 1 bis 20 zu, um das Risiko vorherzusagen, dass ein Kind in den zwei Jahren nach seiner Untersuchung in Pflegefamilien untergebracht wird . „Je höher die Zahl, desto größer das Risiko. Sozialarbeiter entscheiden dann nach eigenem Ermessen, ob sie Nachforschungen anstellen .“

Andere Vorhersagemodelle, die im ganzen Land verwendet werden, zielen darauf ab, „ das Risiko eines Kindes für Tod und schwere Verletzungen einzuschätzen , ob Kinder in Pflegefamilien untergebracht werden sollten und wenn ja, wo“.

Unglaublicherweise gibt es für eine Familie keine Möglichkeit zu wissen, ob die KI-Vorhersagetechnologie dafür verantwortlich war, dass sie angegriffen, untersucht und von ihren Kindern getrennt wurden. Wie der AP feststellt: „Familien und ihre Anwälte können sich auch nie sicher sein, welche Rolle der Algorithmus in ihrem Leben spielt, weil sie die Ergebnisse nicht kennen dürfen .“

Eine Sache, die wir jedoch wissen, ist, dass das System überproportional auf arme, schwarze Familien abzielt, um einzugreifen , zu stören und möglicherweise zu vertreiben, da viele der verwendeten Daten von einkommensschwächeren und Minderheitengemeinschaften stammen.

Auch die Technik ist alles andere als unfehlbar. Allein in einem Landkreis lieferte ein technischer Fehler den Sozialarbeitern falsche Ergebnisse , indem sie das Risiko eines Kindes entweder unterschätzten oder überschätzten.

Ob fehlbar oder nicht, das KI-Vorhersage-Screening-Programm wird im ganzen Land von Regierungsbehörden eingesetzt, um Familien zu überwachen und gezielt zu untersuchen. Die Folge dieser Überüberwachung ist laut Aysha Schomburg, der stellvertretenden Kommissarin des US Children’s Bureau, eine „ Massentrennung von Familien “.

Die Auswirkungen dieser Art von KI-Vorhersagewerkzeugen sind in fast allen Lebensbereichen zu spüren.

Unter dem Vorwand, überforderten Regierungsbehörden zu helfen, effizienter zu arbeiten, werden KI-Vorhersage- und Überwachungstechnologien eingesetzt, um die Bevölkerung zu klassifizieren, zu trennen und zu kennzeichnen, ohne sich um Datenschutzrechte oder ordnungsgemäße Verfahren zu kümmern.

All dieses Sortieren, Sichten und Berechnen erfolgt schnell, heimlich und unaufhörlich mit Hilfe von KI-Technologie und einem Überwachungsstaat , der jede Ihrer Bewegungen überwacht.

Besonders gefährlich wird dies, wenn die Regierung vorbeugende Maßnahmen ergreift, um Kriminalität oder Missbrauch zu bekämpfen, oder was immer die Regierung zu einem bestimmten Zeitpunkt verbieten möchte.

Auf diese Weise können Regierungsagenten – mit Hilfe von automatisierten Augen und Ohren, einem wachsenden Arsenal an Hightech-Software, -Hardware und -Techniken, Regierungspropaganda, die Amerikaner dazu drängt, sich in Spione und Spitzel zu verwandeln, sowie soziale Medien und Software zur Verhaltenserkennung – spinnen ein klebriges Spinnennetz aus Bedrohungsbewertungen, Verhaltenserkennungswarnungen, markierten „Wörtern“ und „verdächtigen“ Aktivitätsberichten, die darauf abzielen, potenzielle Staatsfeinde zu fangen.

Sind Sie ein Militärveteran, der an einer posttraumatischen Belastungsstörung leidet? Haben Sie in den sozialen Medien kontroverse, mutlose oder verärgerte Ansichten geäußert? Arbeiten Sie mit Personen zusammen, die vorbestraft sind oder Verschwörungstheorien abonnieren? Wurden Sie im Supermarkt wütend gesehen? Wirkt Ihr Auftreten in der Öffentlichkeit ungepflegt? War Ihre Fahrweise unberechenbar? Hatten die früheren Bewohner Ihres Hauses Zusammenstöße mit der Polizei?

All diese Details und mehr werden von der KI-Technologie verwendet, um ein Profil von Ihnen zu erstellen, das sich auf Ihren Umgang mit der Regierung auswirkt.

Es ist der amerikanische Polizeistaat, der zu einem unterdrückerischen Paket aus vorkrimineller und vorgedachter Kriminalität zusammengerollt ist, und das Endergebnis ist der Tod eines ordnungsgemäßen Verfahrens.

Kurz gesagt, ein ordnungsgemäßes Verfahren war als Bollwerk gegen den Missbrauch durch die Regierung gedacht. Ein ordnungsgemäßes Verfahren verbietet der Regierung, jemandem „Leben, Freiheit und Eigentum“ zu entziehen, ohne zuvor sicherzustellen, dass die Rechte einer Person anerkannt und respektiert wurden und dass sie die Möglichkeit erhalten haben, die gegen sie erhobenen Anklagen zu erfahren und sich gegen diese Anklagen zu verteidigen.

Mit dem Aufkommen von staatlich finanzierten KI-Programmen für vorausschauende Polizeiarbeit, die jemanden überwachen und als potenzielle Bedrohung kennzeichnen, die untersucht und als gefährlich behandelt werden soll, kann es keine Garantie für ein ordnungsgemäßes Verfahren geben: Sie wurden bereits zu einem Verdächtigen gemacht.

Um sich von den Folgen einer solchen Bedrohungsbewertung zu befreien, liegt die Beweislast bei Ihnen, um Ihre Unschuld zu beweisen.

Siehst du das Problem?

Früher hatte jeder das Recht, bis zum Beweis seiner Schuld als unschuldig zu gelten, und die Beweislast lag bei den Anklägern. Diese Unschuldsvermutung wurde seitdem durch einen Überwachungsstaat auf den Kopf gestellt, der uns alle zu Verdächtigen macht, und durch eine Überkriminalisierung, die uns alle potenziell des einen oder anderen Fehlverhaltens schuldig macht.

Kombinieren Sie prädiktive KI-Technologie mit Überwachung und Überkriminalisierung, fügen Sie dann eine militarisierte Polizei hinzu, die mitten in der Nacht durch Türen stürzt, um einen routinemäßigen Haftbefehl zu verbüßen, und Sie können sich glücklich schätzen, mit Ihrem Leben davonzukommen.

Seien Sie jedoch gewarnt: Sobald Sie von einer Überwachungskamera erwischt, von einem KI-Vorhersage-Screening-Programm markiert und auf eine Beobachtungsliste der Regierung gesetzt werden – sei es eine Beobachtungsliste für Kindesvernachlässigung, eine Beobachtungsliste für psychische Gesundheit, eine Beobachtungsliste für Dissidenten usw Terroristen-Beobachtungsliste oder eine Waffen-Beobachtungsliste mit roter Flagge – es gibt keinen eindeutigen Weg, um auszusteigen, ob Sie tatsächlich darauf stehen sollten oder nicht.

Sie werden überall verfolgt, als potenzielle Bedrohung gekennzeichnet und entsprechend behandelt.

Wenn Sie noch keine Angst haben, sollten Sie es sein.

Wir haben es der Regierung zu einfach gemacht, jeden zu identifizieren, zu kennzeichnen, anzuvisieren, zu entschärfen und zu verhaften, der aus einer Vielzahl von Gründen, die von einer psychischen Erkrankung über einen militärischen Hintergrund bis hin zur Anfechtung ihrer Autorität reichen, aus einer Vielzahl von Gründen eine potenzielle Bedrohung darstellt auf der Liste der Persona non grata der Regierung zu stehen.