Kalifornische Programmierer waren die ersten, die demonstrierten, dass ein Deepfake-Detektor ausgetrickst werden kann. Das teilte der Pressedienst der Cornell University mit. Die Programmierer weigerten sich, ihren Code im Open Access zu veröffentlichen, damit er nicht dazu verwendet werden könnte, die Realität für illegale Zwecke zu verzerren.

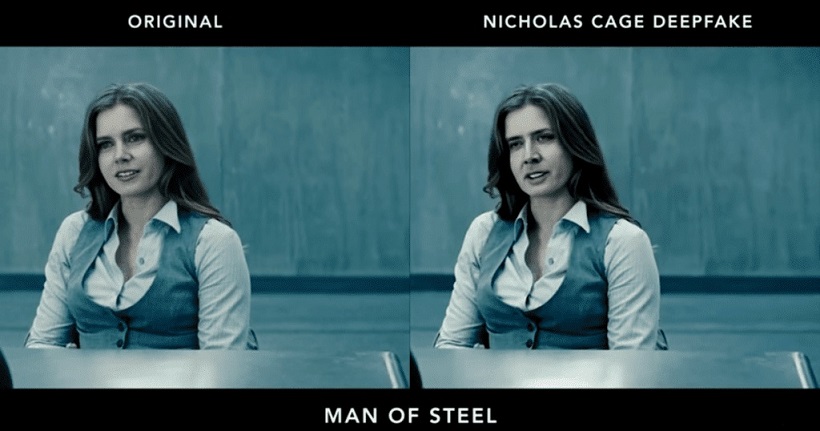

Mit der Deepfake-Technologie oder Deepfake können Sie das Gesicht eines beliebigen Themas in das eines anderen ändern. Gleichzeitig wirkt die neue Version des Bildes recht glaubwürdig. Mithilfe eines Deepfakes können Sie realistische Aufnahmen von Ereignissen erstellen, die in der Realität nicht stattgefunden haben.

In Bezug auf die Arbeit amerikanischer Spezialisten für Computertechnik ist ein neues neuronales Netzwerk eine ziemlich einfache Möglichkeit, alle Deepfake-Detektoren zu „betrügen“. Dieser Algorithmus wurde auf der Winter Conference on the Applications of Computer Vision vorgestellt, die im Januar dieses Jahres stattfand ( WACV 2021 ). Die Forscher bestehen darauf, dass ihre Lösung die Ineffektivität selbst der fortschrittlichsten verfügbaren Videoauthentifizierungstools demonstriert.

Die Methode der Täuschung besteht darin, spezielle „Gegner“ – gegnerische Beispiele in jeden Frame des Videos einzubetten. Der Effekt ist wahrlich entmutigend: Selbst ein hastig zusammengebrauter Deepfake wird vom Detektor als echte Aufnahme erkannt. Obwohl das unnatürliche Verhalten einer Person in dem Video mit bloßem Auge offensichtlich ist. Forscher haben ein Beispiel für eine solche Täuschung in der Praxis demonstriert.

Wichtig ist, dass der „Snag“ für die Videotranscodierung und auf vielen der fortschrittlichsten Detektoren funktioniert. Tatsächlich kommen Experten zu dem Schluss, dass es aufgrund der Besonderheiten der Algorithmen zur Erkennung von Fälschungen sehr einfach ist, sie alle einzukreisen.

Solche Entwicklungen können viel perfekter werden, was wiederum das eigentliche Konzept des Vertrauens in die Videosequenz in Frage stellt. Genauer gesagt gibt es Anlass zur Sorge, dass die Manipulation der öffentlichen Meinung für Angreifer viel einfacher sein könnte, als es den Strafverfolgungsbehörden und den Menschen selbst lieb ist. Und wurde die Deepfake-Welle zunächst nur als Unterhaltung wahrgenommen, so wurde wenig später die Gefahr der Technologie offensichtlich.

Menschen sind es gewohnt, dem zu vertrauen, was sie mit ihren Augen sehen, und ein gut gemachter Deepfake kann von einem echten Video nicht zu unterscheiden sein. Manchmal reicht es nicht einmal, das Gesicht einer Person zu ersetzen, sondern Lippenbewegungen mit falscher Sprache zu synchronisieren. Der Umfang der möglichen Verwendung solcher Manipulationen ist wirklich grenzenlos. Und Detektoren für solche Fälschungen werden von Hunderten von Teams auf der ganzen Welt entwickelt.